DeepSeek本地部署操作指南

一、环境准备

(一)硬件需求DeepSeek的最低配置要求为:CPU必须支持AVX2指令集,并配备至少16GB的内存和30GB的存储空间。若要充分发挥其性能,推荐使用NVIDIA GPU,如RTX 3090或更高版本,并配备32GB内存和50GB存储空间。

(二)软件依赖DeepSeek支持在Windows、macOS或Linux操作系统上运行。若选择使用Open Web UI,则需安装Docker软件。

二、安装Ollama

Ollama是一款开源工具,旨在为本地运行和部署大型语言模型提供便捷。接下来,我们将介绍如何安装Ollama:1、访问Ollama官网并下载安装包:首先,你需要前往Ollama的官方网站。在网站上,找到并点击“Download”按钮,开始下载适合你操作系统的安装包。下载完成后,直接双击安装文件,并遵循安装向导的指示完成安装过程。

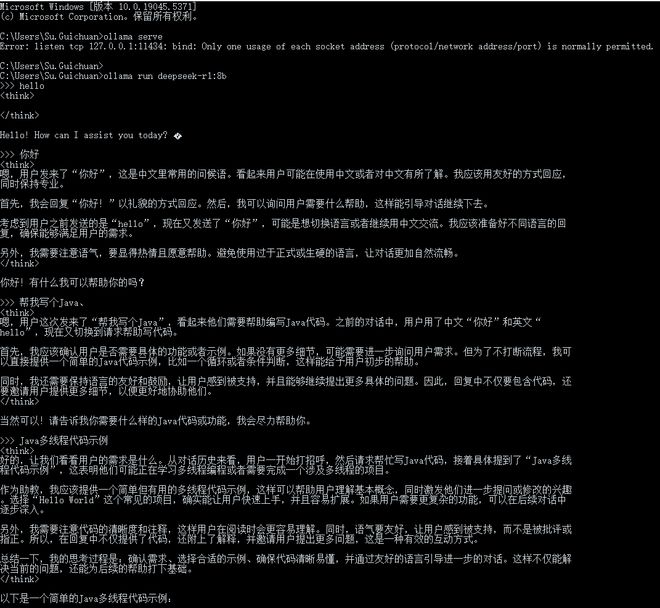

2、验证Ollama安装:安装完毕后,打开终端(或命令提示符),输入以下命令来检查Ollama的版本:

如果终端输出显示了版本号(例如“ollama version is 0.5.6”),那就意味着Ollama已经成功安装在你的系统上了。

三、下载并部署DeepSeek模型

Ollama平台支持多种DeepSeek模型版本,用户可根据自身硬件条件来选择合适的模型。以下是详细的部署步骤:

选择模型版本:

下载模型:

启动Ollama服务:

四、利用Open Web UI进行直观交互(可选)

为了以更直观的方式与DeepSeek模型进行交互,用户可以选择使用Open Web UI。以下是关于其安装与使用的详细步骤:1、安装Docker:请确保您的计算机上已安装Docker。

2、运行Open Web UI:在终端中执行以下命令,以安装并启动Open Web UI:docker run -d -p 30008080 --add-host host.docker.internal:host-gateway -v open-webui/app/backend/data:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui main

安装完毕后,通过访问http://localhost:3000,并选择deepseek-r1.latest模型,您即可开始使用Open Web UI与DeepSeek模型进行直观交互。

五、性能优化与资源管理

资源分配:依据您的硬件配置来挑选适合的模型版本。在标准硬件上,规模较小的模型(例如,1.5B至14B)能够表现出色,而大型模型(例如,32B和70B)则需配备更强劲的GPU。

内存管理:请确保您的系统拥有充足的内存和存储空间,以防范运行时资源不足的情况。

六、常见问题及解决方法

模型下载超时:若在下载模型时遭遇超时,建议重新尝试运行下载指令。

服务启动失败:请确认Ollama服务已妥当安装并已启动。若服务无法启动,可尝试重启Ollama服务以解决问题。

七、总结

遵循上述详尽步骤,你已能够在本地顺利部署DeepSeek模型,并通过Ollama或Open Web UI与模型进行便捷交互。这种本地部署方式不仅有助于保护数据隐私,还能让你根据实际需求灵活调整模型参数,从而更好地适应各种使用场景。若在部署过程中遇到任何难题,欢迎在评论区留言,我们将携手为你排忧解难。愿你通过这篇教程,能够顺利部署DeepSeek模型,从而踏上高效开发的崭新旅程!三分钟,即可拥有你的专属AI助手。

八、操作指南:

首先,打开浏览器,在地址栏输入「www.deepseek.com」,即可轻松访问我们的官方网站。接下来,点击页面右上角的「笑脸图标」,选择「邮箱/手机注册」选项,并填写常用邮箱进行注册。注册完成后,请务必查看收件箱中的验证邮件,并点击蓝色确认按钮完成身份验证。

九、避坑指南:

在操作过程中,可能会遇到验证码不显示的问题。此时,可以尝试刷新页面或切换浏览器重新操作。另外,为了确保账号安全,建议在注册后立即绑定手机号,以便在需要时能够方便地找回账号。